【笔记】Scrapyd学习笔记

前言

通过Scrapyd实现Scrapy爬虫的远程部署

服务端

- 用来运行爬虫代码

下载依赖

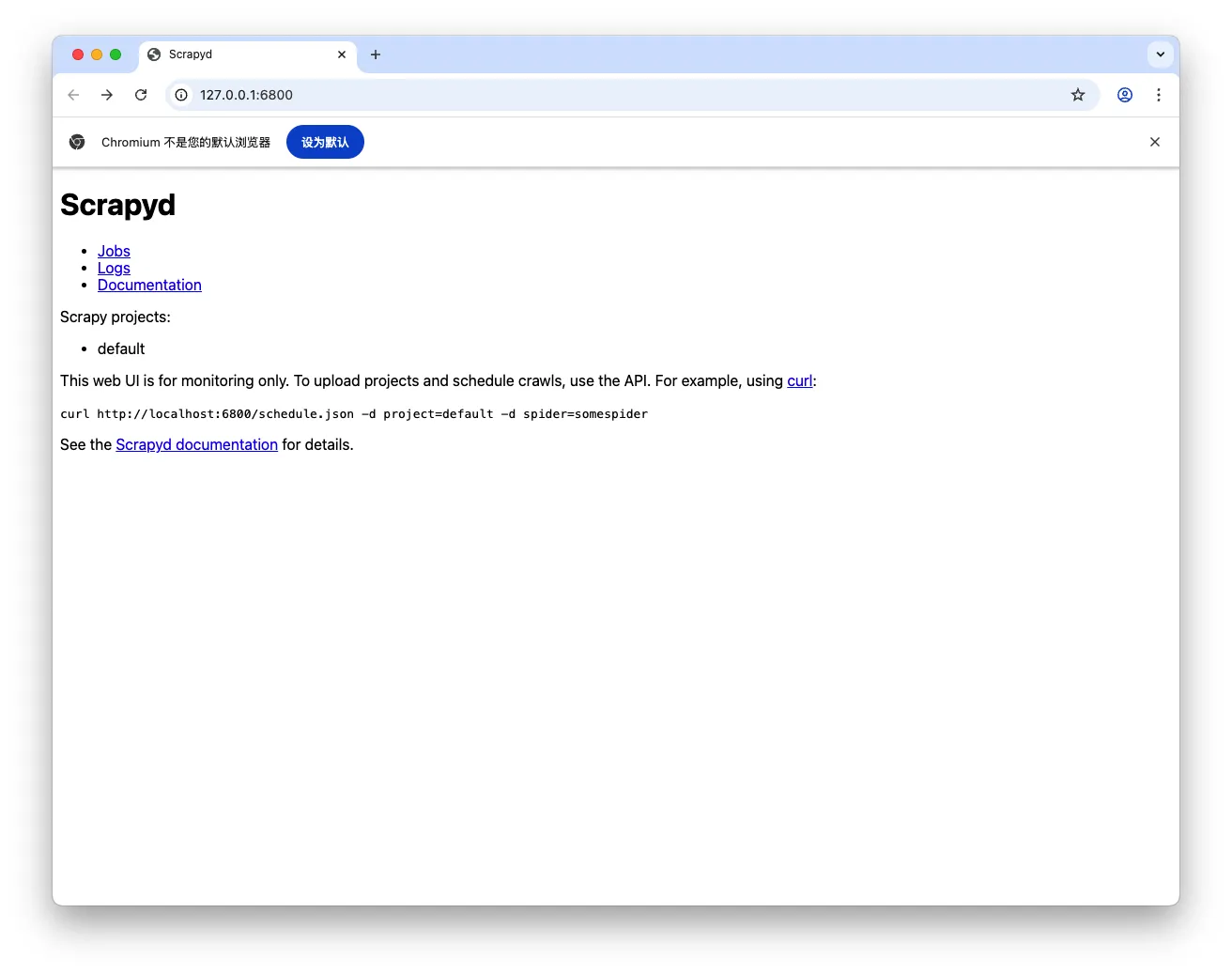

1 | pip3 install scrapyd |

启动服务端

1 | scrapyd |

客户端

- 用来将写好的爬虫代码交给服务端运行

下载依赖

1 | pip3 install scrapyd-client |

修改配置文件

<deploy_name>:定义一个部署名

1 | [deploy:<deploy_name>] |

部署到服务端

1 | scrapy-deploy <deploy_name> -p <project_name> |

通过API操作服务端的项目

在服务端运行爬虫

1 | curl http://127.0.0.1:6800/schedule.json -d project=<project_name> -d spider=<spider_name> |

在服务端停止爬虫

1 | curl http://127.0.0.1:6800/cancel.json -d project=<project_name> -d job=<job_id> |

列出服务端所有的项目

1 | curl http://127.0.0.1:6800/listprojects.json |

列出服务端指定项目的所有的爬虫

1 | curl http://127.0.0.1:6800/listspiders.json?project=<project_name> |

列出服务端指定项目的所有的作业

1 | curl http://127.0.0.1:6800/listjobs.json?project=<project_name> |