【笔记】Windows上部署本地知识库

前言

通过Ollama的deepseek-r1模型和AnythingLLM部署本地的AI知识库

模型选择

deepseek

- 官方提供的模型是满血版和蒸馏版,Ollama提供的模型均为量化版

| 版本 | 名称 | 模型大小(需要占用显存大小单位G) | 模型参数(单位亿个) |

|---|---|---|---|

| 满血版 | DeepSeek-R1 | 6710 | |

| 蒸馏版 | DeepSeek-R1-Distill-Llama-70B | 150 | 700 |

| 蒸馏版 | DeepSeek-R1-Distill-Qwen-32B | 66 | 320 |

| 蒸馏版 | DeepSeek-R1-Distill-Qwen-14B | 30 | 140 |

| 蒸馏版 | DeepSeek-R1-Distill-Llama-8B | 16 | 80 |

| 蒸馏版 | DeepSeek-R1-Distill-Qwen-7B | 15 | 70 |

| 蒸馏版 | DeepSeek-R1-Distill-Qwen-1.5B | 3.5 | 15 |

| 满血量化版 | deepseek-r1:671b | 404 | 6710 |

| 蒸馏量化版 | deepseek-r1:70b | 43 | 700 |

| 蒸馏量化版 | deepseek-r1:32b | 20 | 320 |

| 蒸馏量化版 | deepseek-r1:14b | 9 | 140 |

| 蒸馏量化版 | deepseek-r1:8b | 4.9 | 80 |

| 蒸馏量化版 | deepseek-r1:7b | 4.7 | 70 |

| 蒸馏量化版 | deepseek-r1:1.5b | 1.1 | 15 |

下载依赖

1 | winget install Ollama.Ollama |

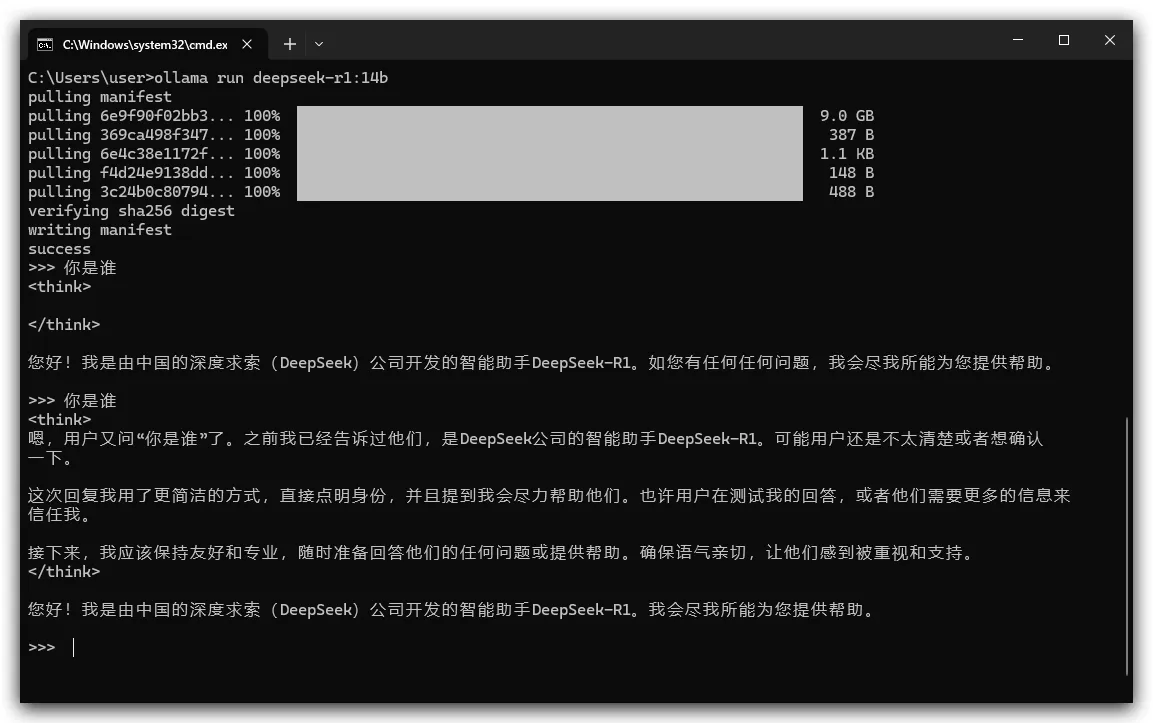

下载模型

1 | ollama run deepseek-r1 |

- 访问http://127.0.0.1:11434会返回

lama is running

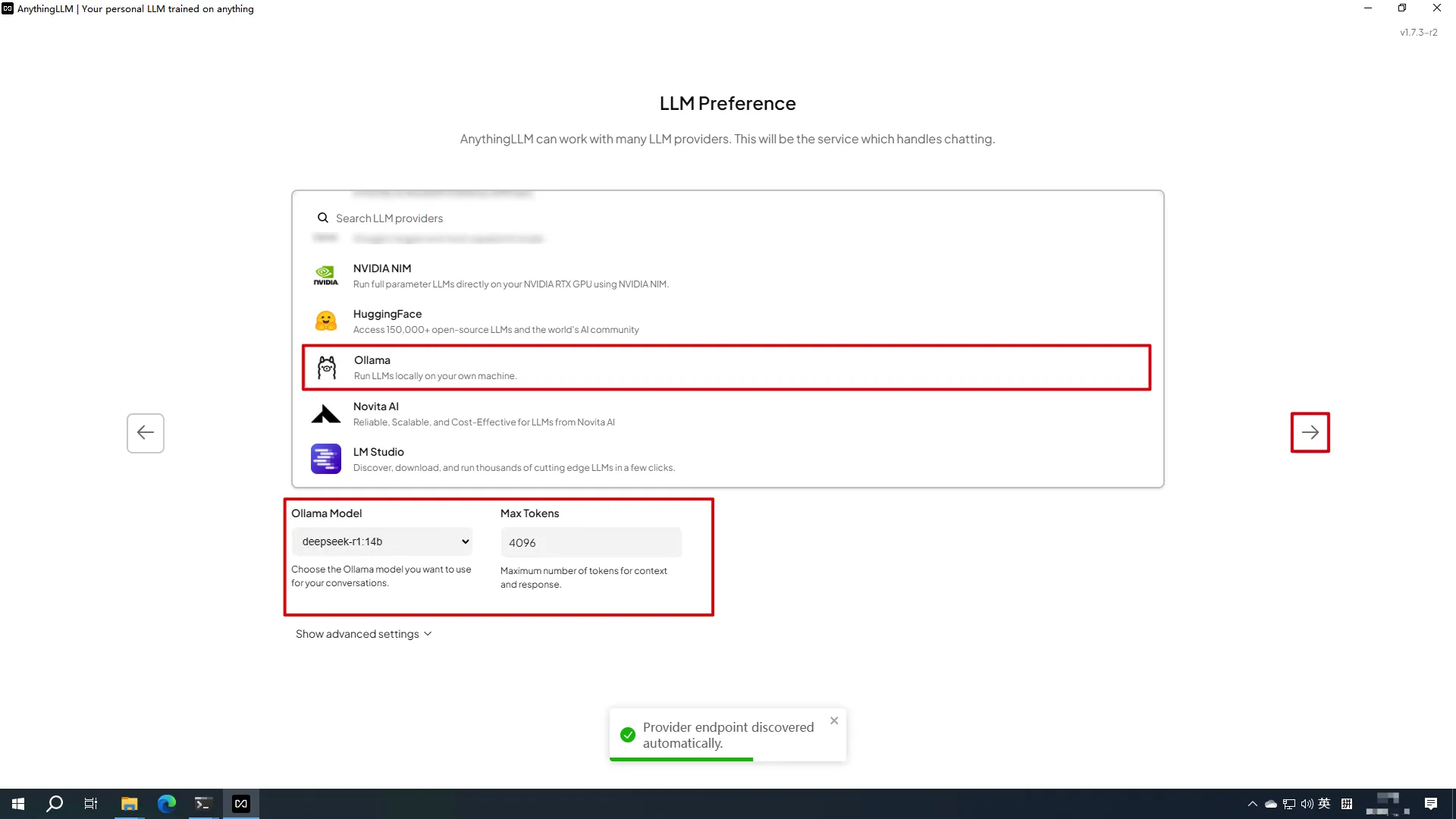

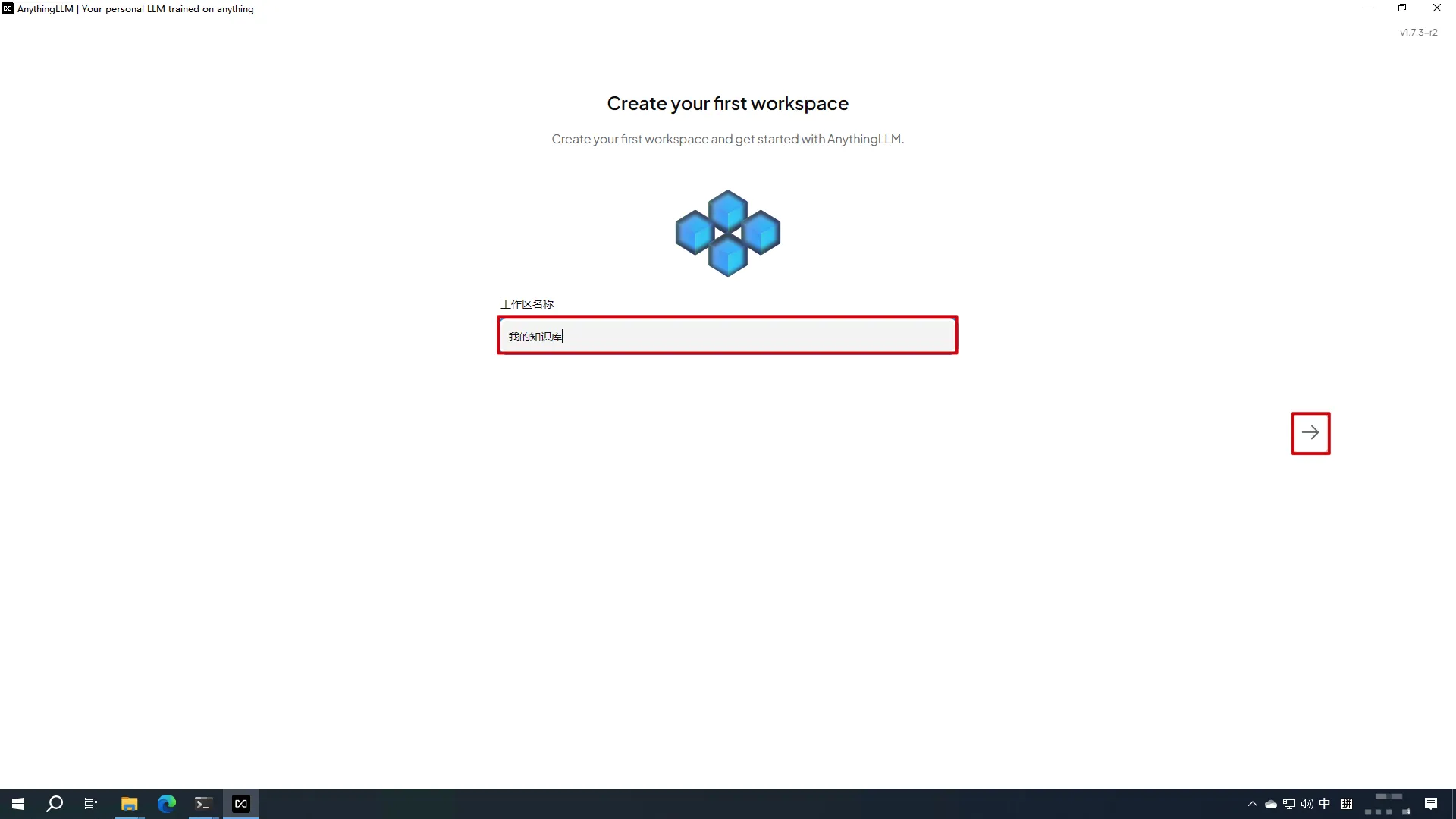

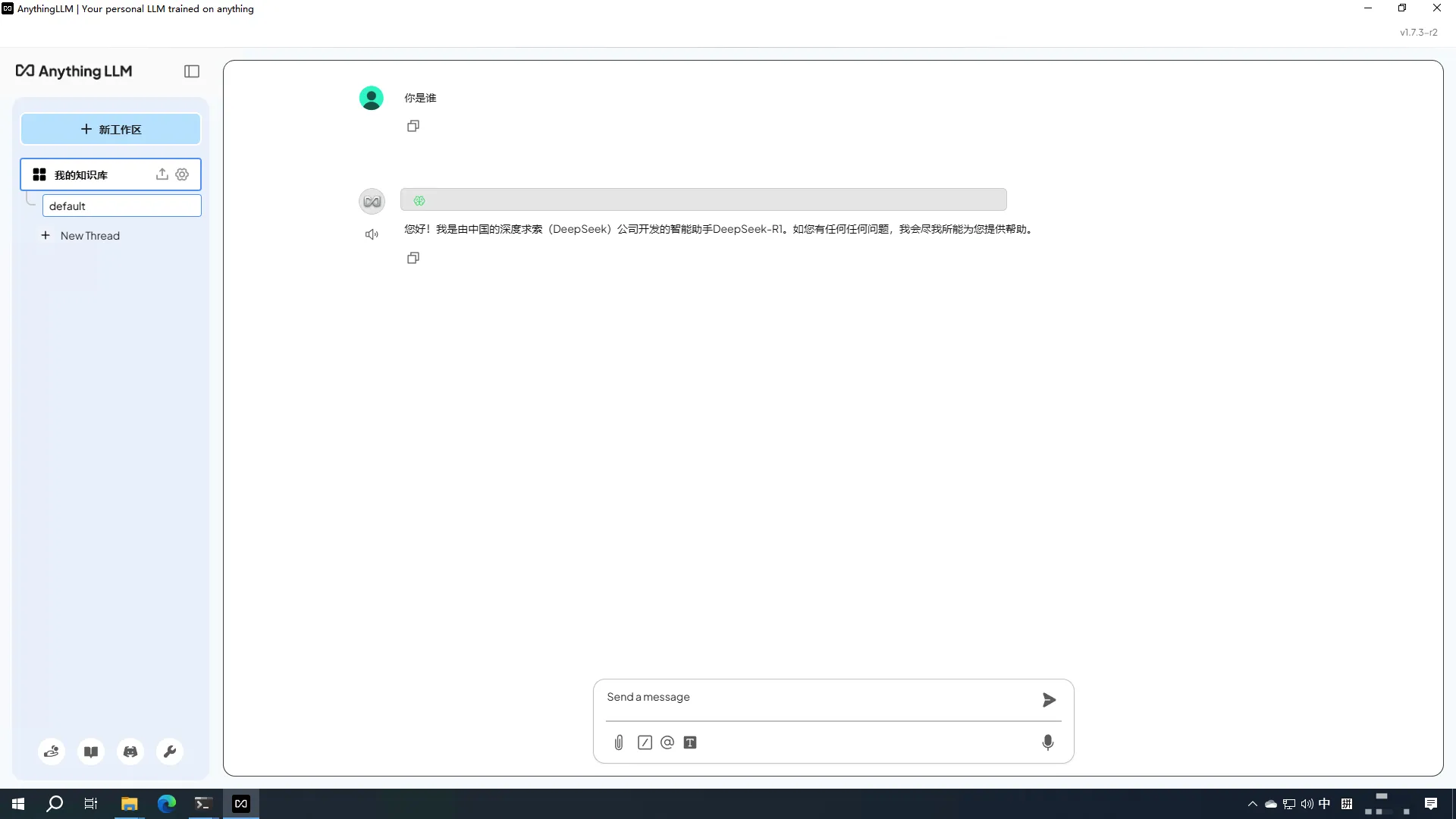

初始化AnythingLLM

- 打开AnythingLLM->选择

Ollama

- 下一步

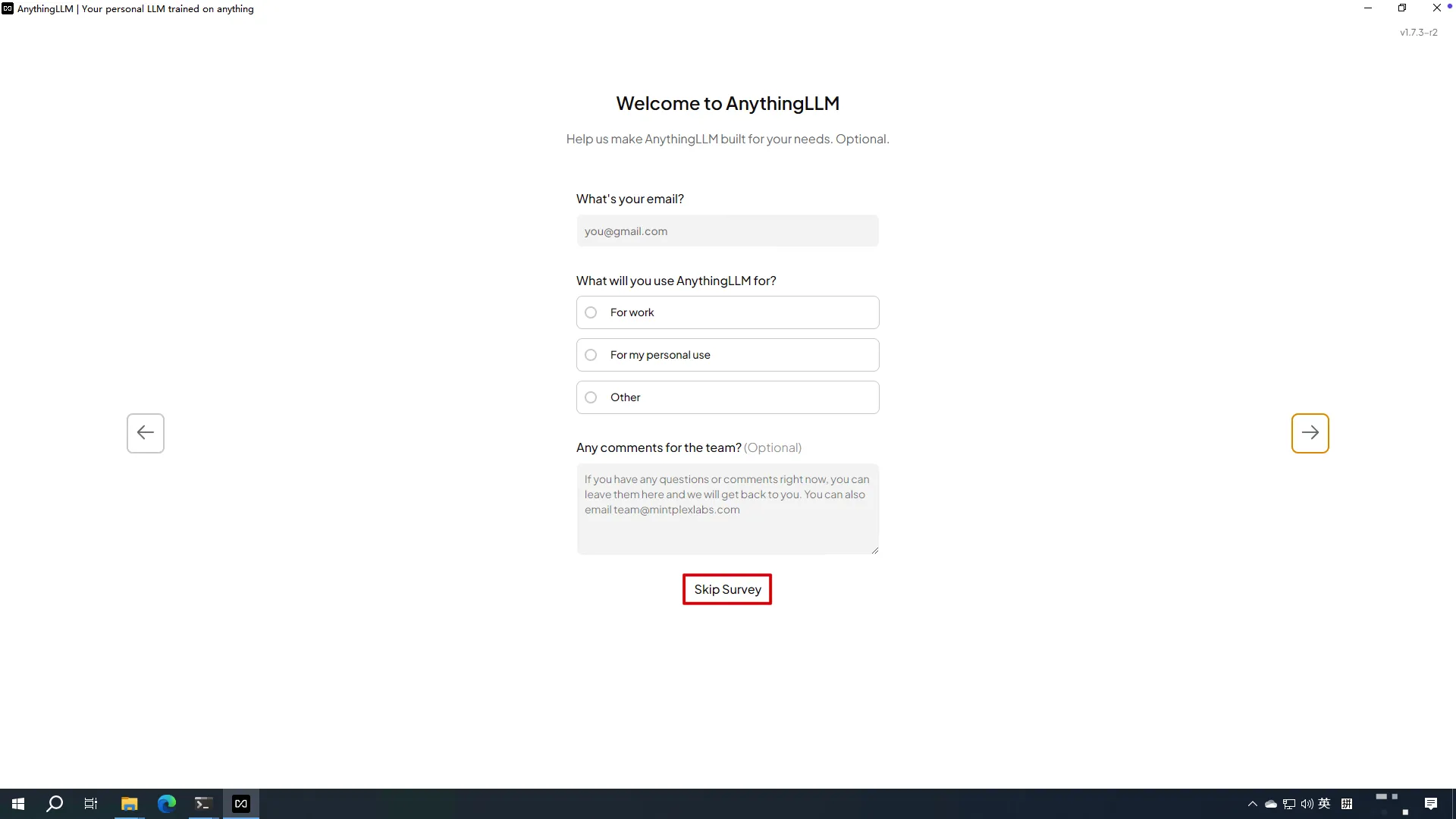

Skip Survey

- 设置工作区名称,下一步

- 完成

修改AnythingLLM语言

- 打开设置

外观->Display Language设置为Chinese

- 返回

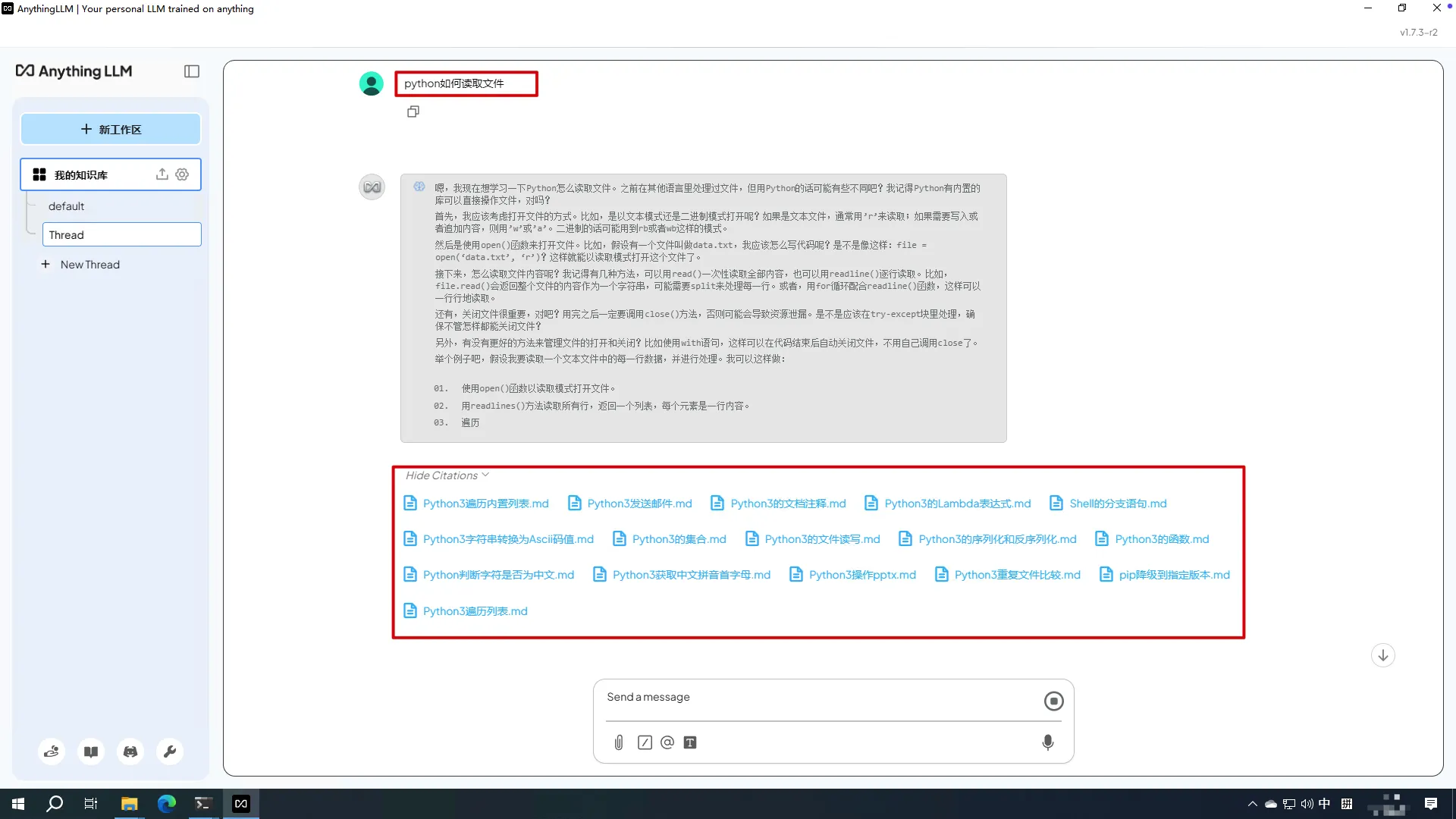

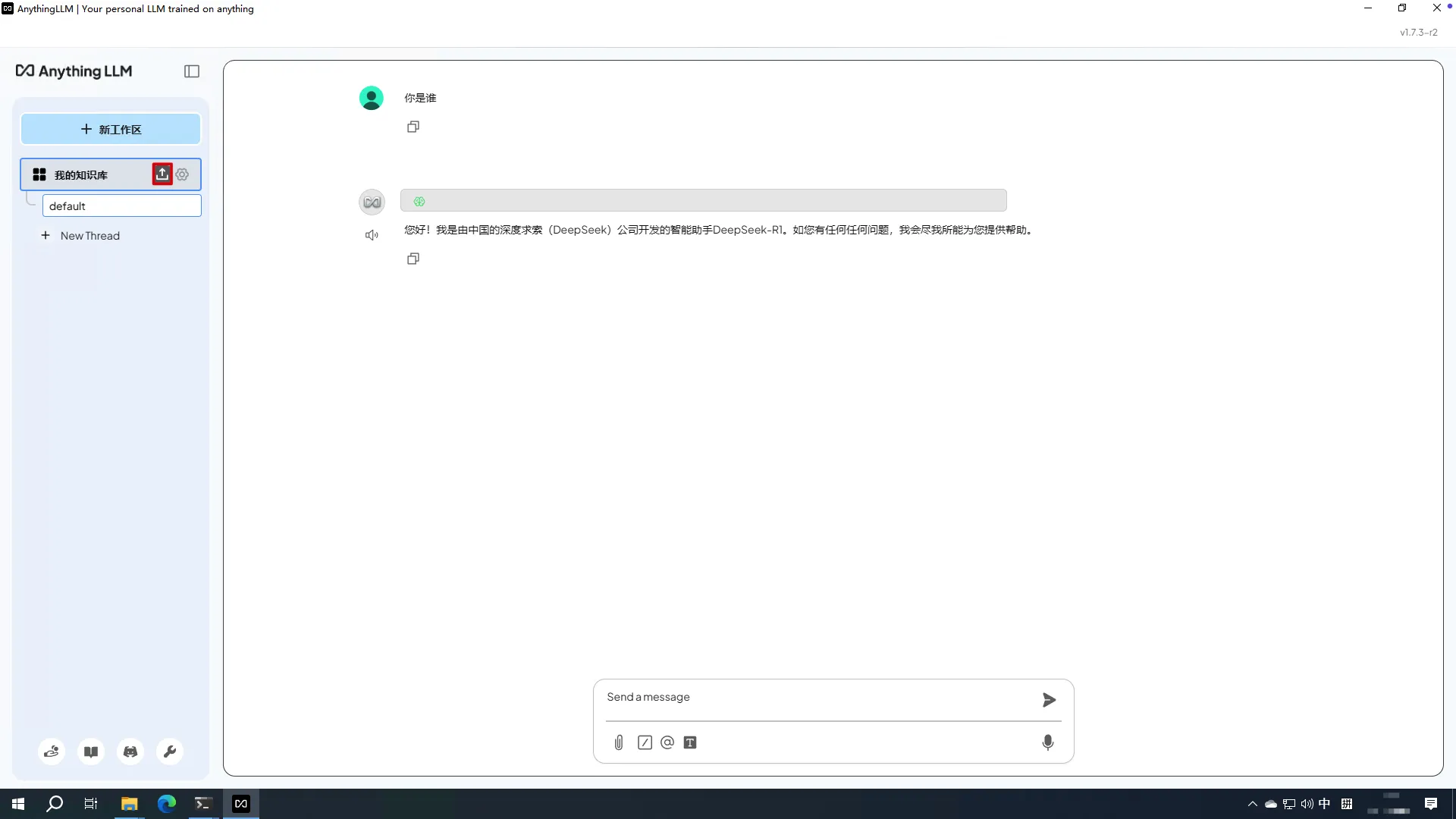

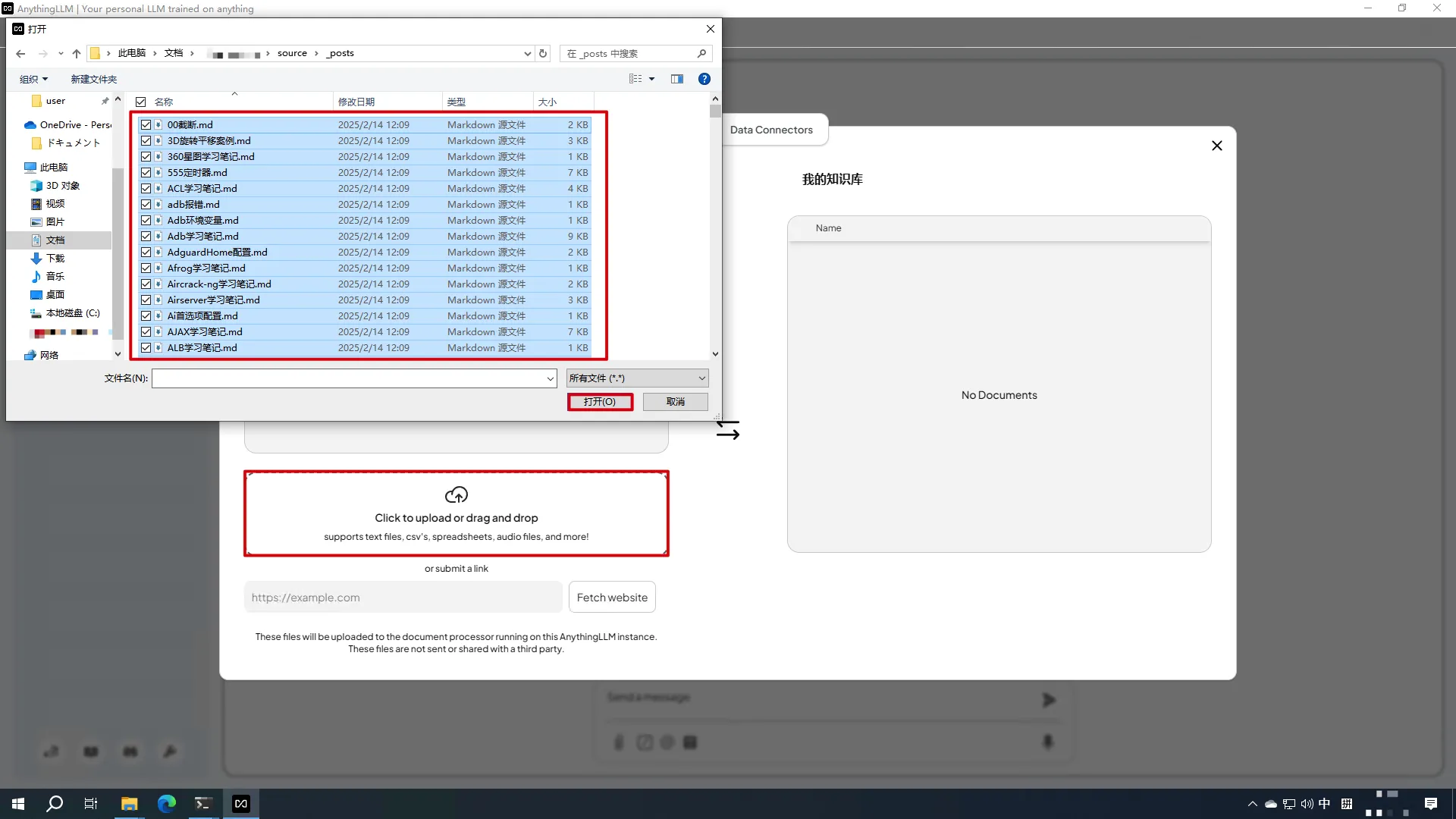

构建知识库

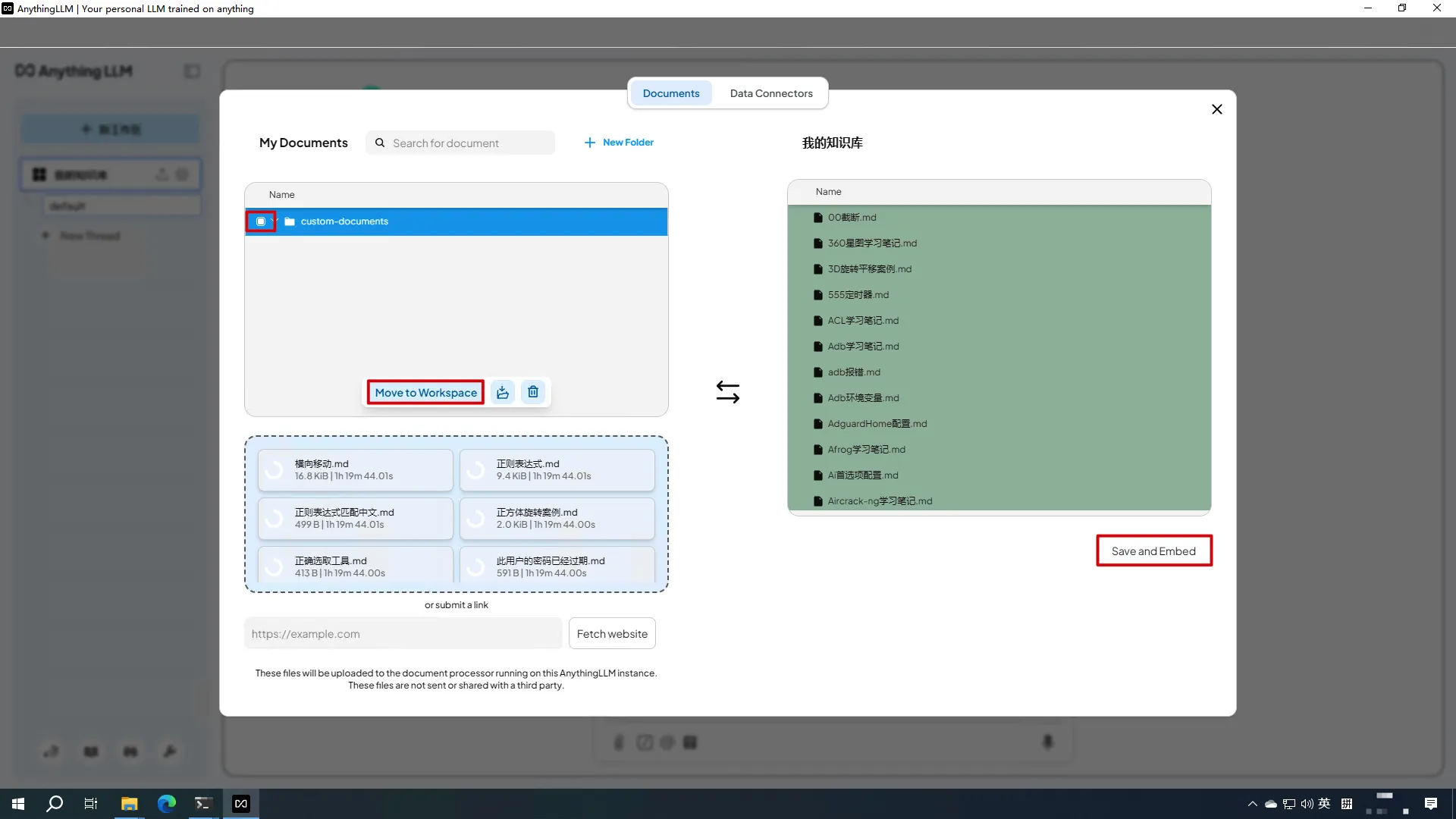

上传内部文档

- 在工作区上点击上传按钮

Click to upload or drag and drop->选择文档->打开

- 全选上传的文档->

Move to Workspace->Save and Embed

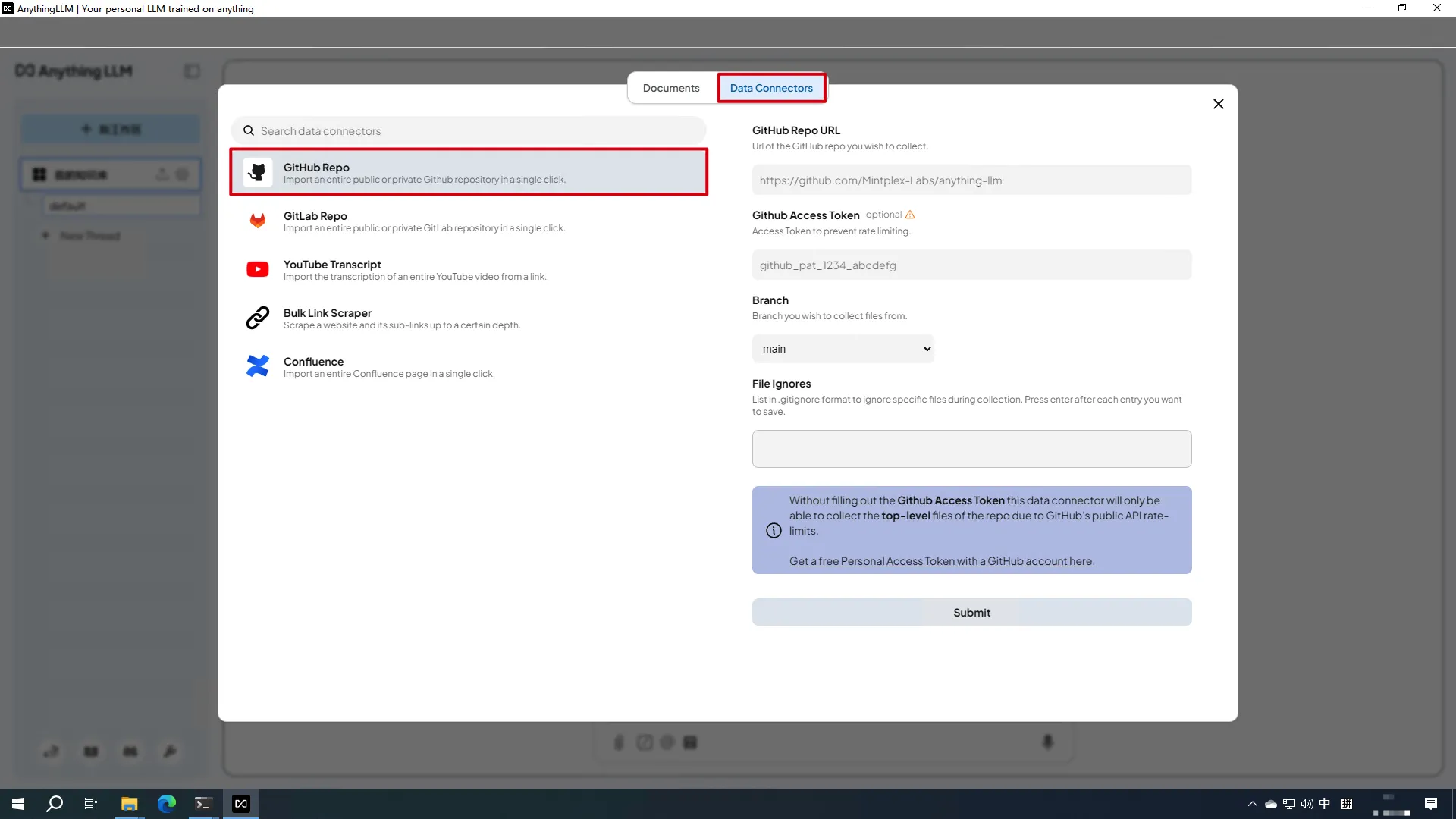

读取Github仓库

Data Connectors->Github Repo

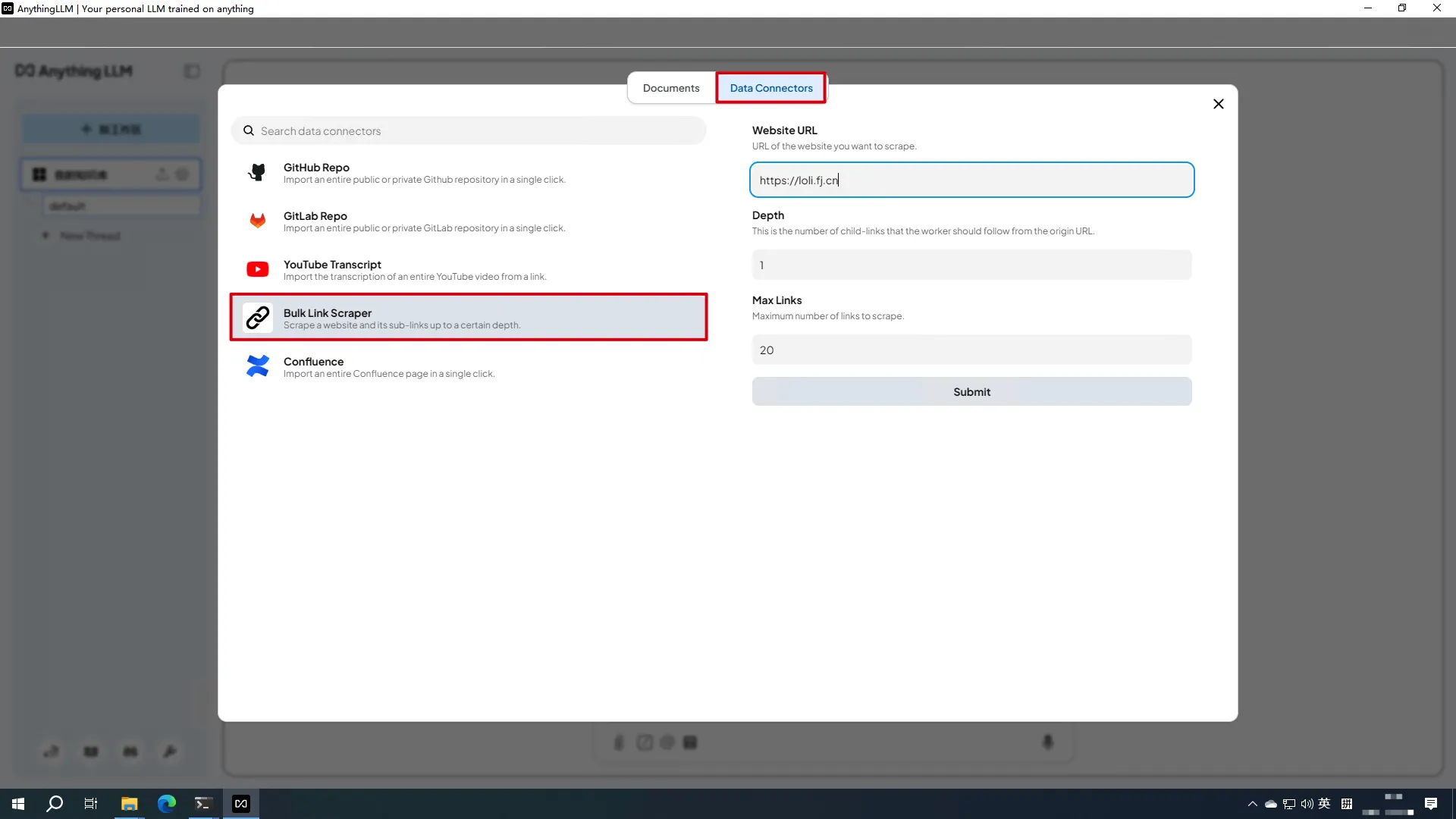

爬虫爬取网站

Data Connectors->Bulk Link Scraper

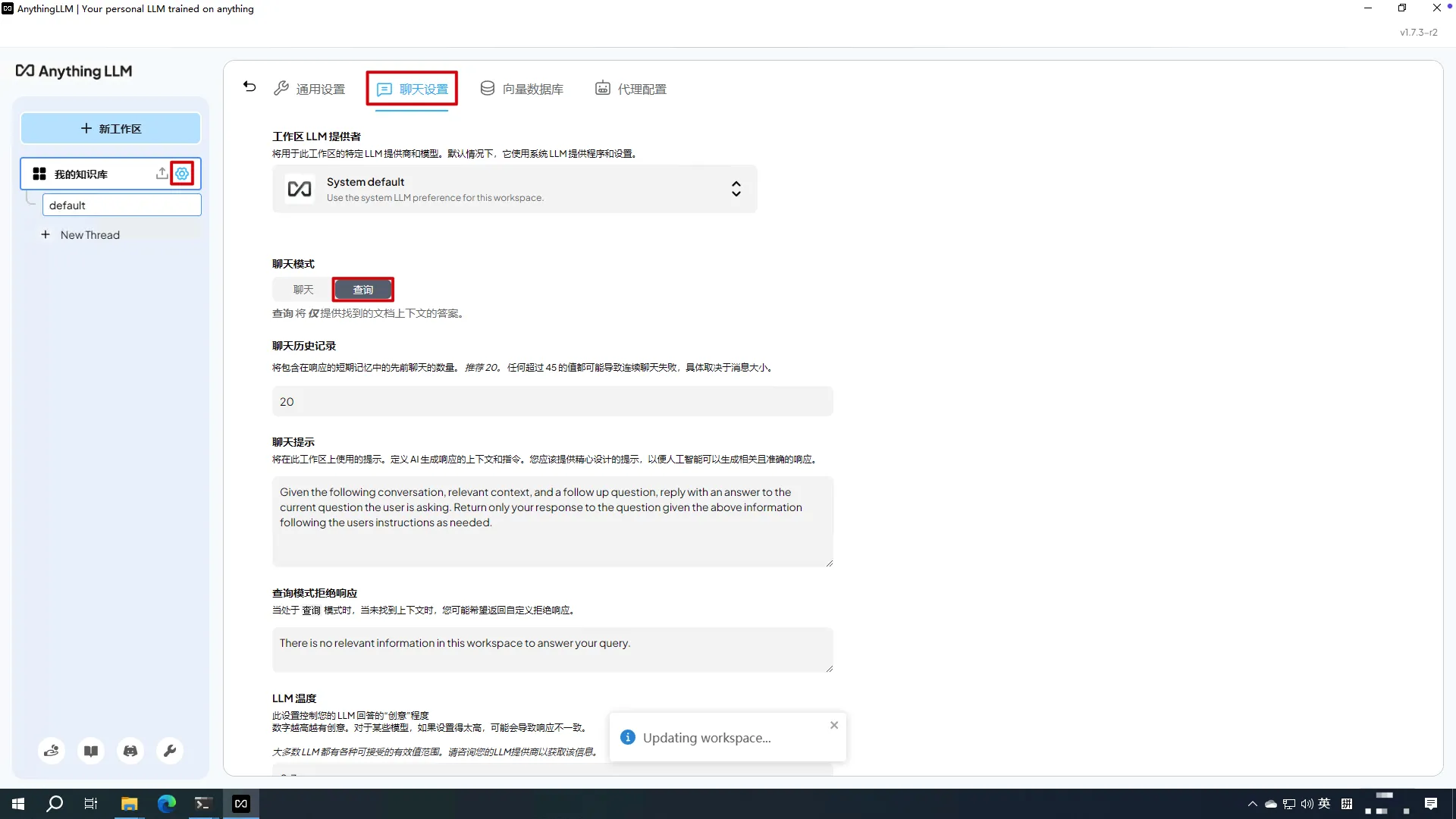

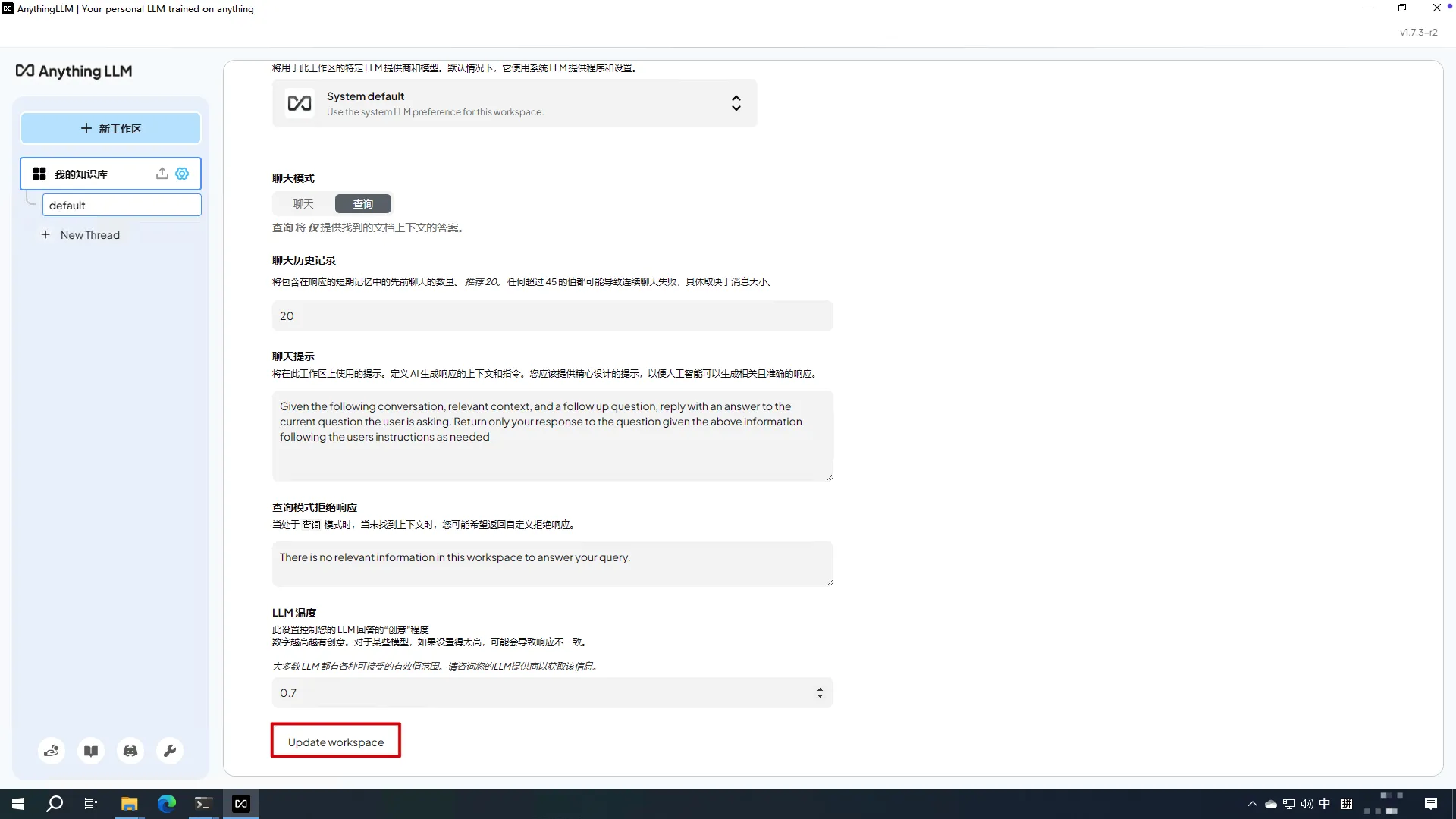

修改AnythingLLM聊天模式

- 在工作区上点击设置按钮->

聊天设置->修改聊天模式为查询模式

Update workspace

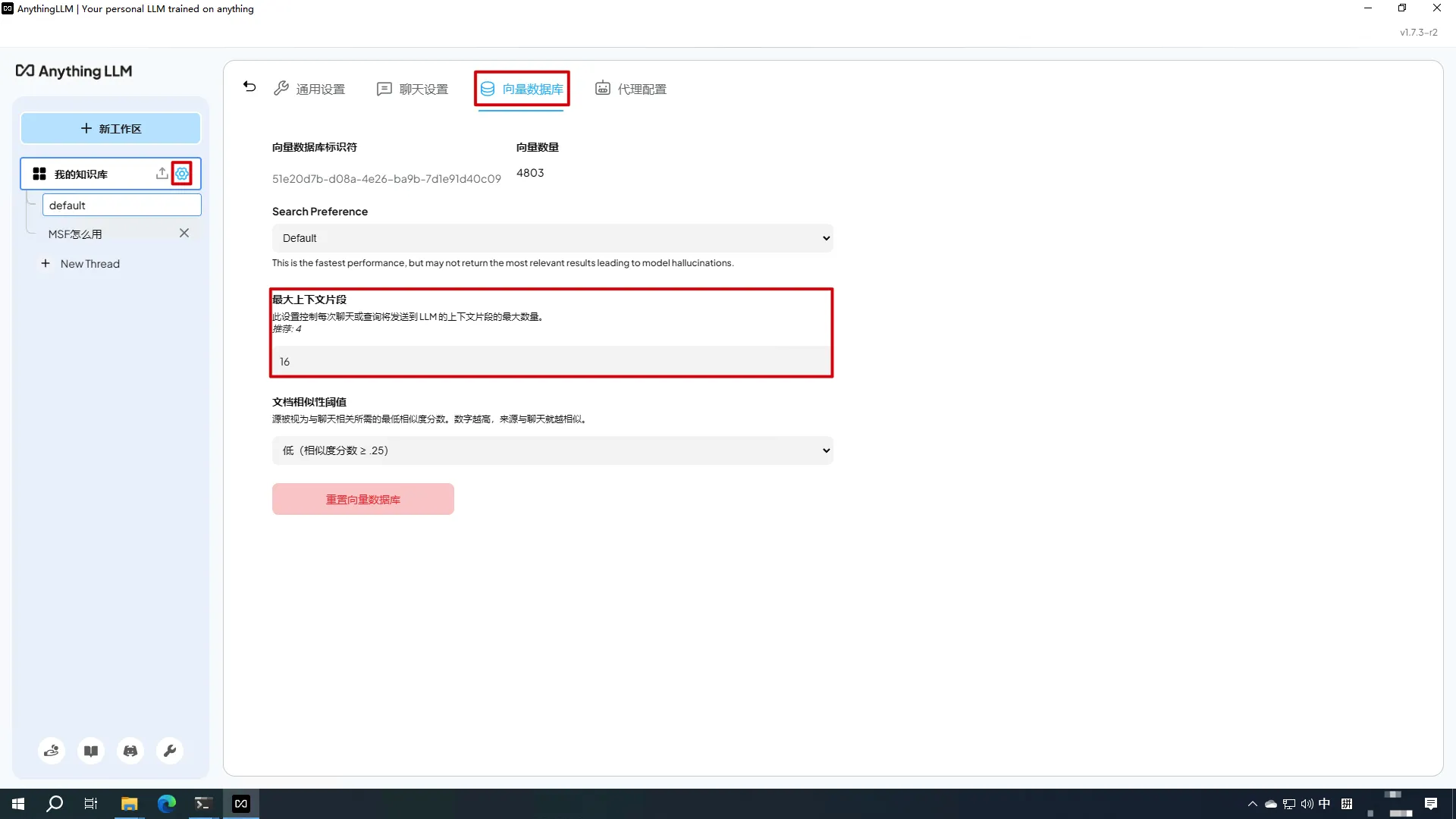

修改AnythingLLM向量数据库设置

- 在工作区上点击设置按钮->

向量数据库->修改最大上下文片段

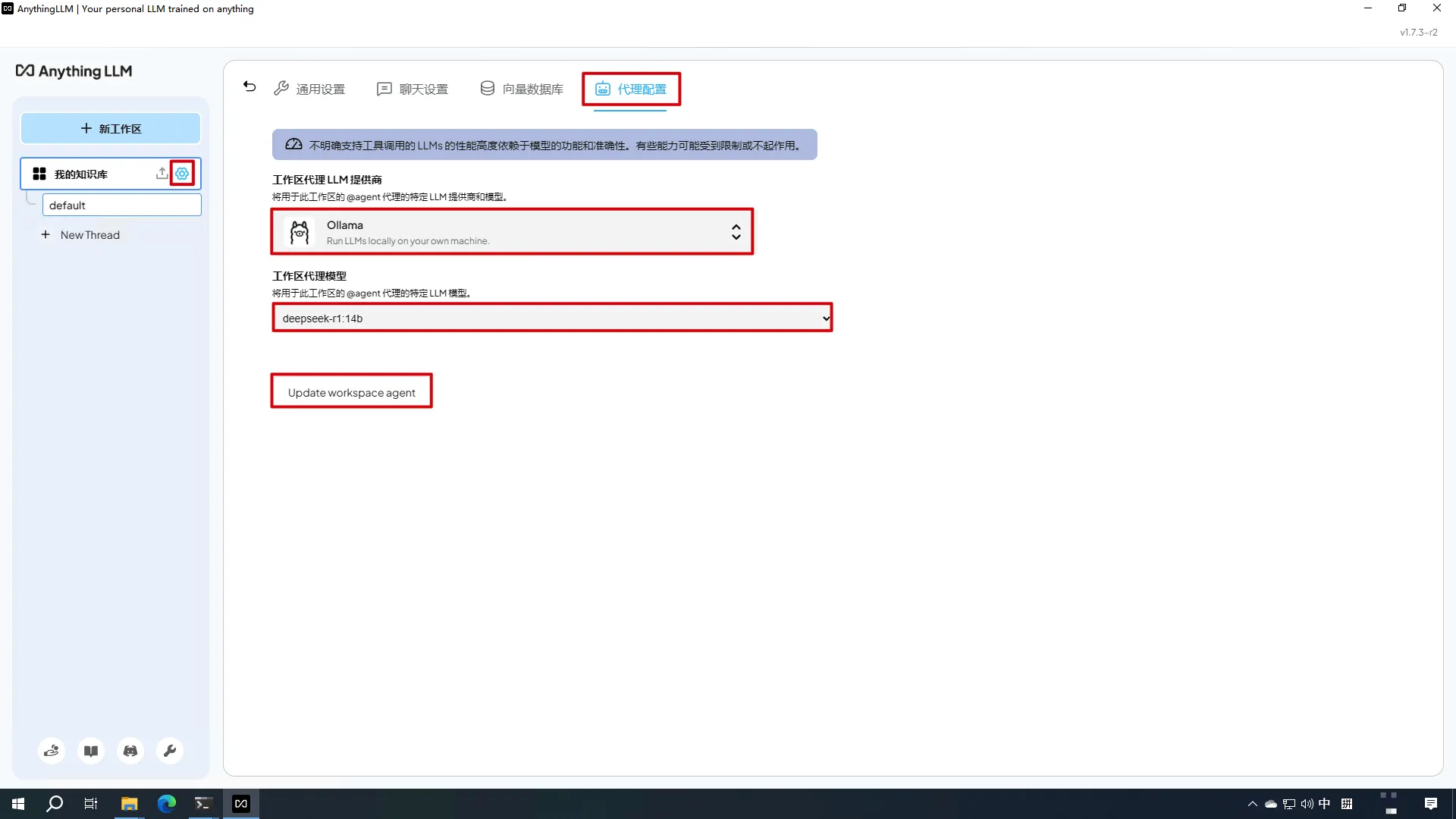

修改AnythingLLM代理设置

- 在工作区上点击设置按钮->

代理设置->选择工作区代理LLM提供商和工作区代理模型->Update workspace

完成

- 截图纪念